Notícia | IA com Direitos | Plataformas e Mercados Digitais

Um geralzão sobre o debate de regulação para Inteligência Artificial no Brasil

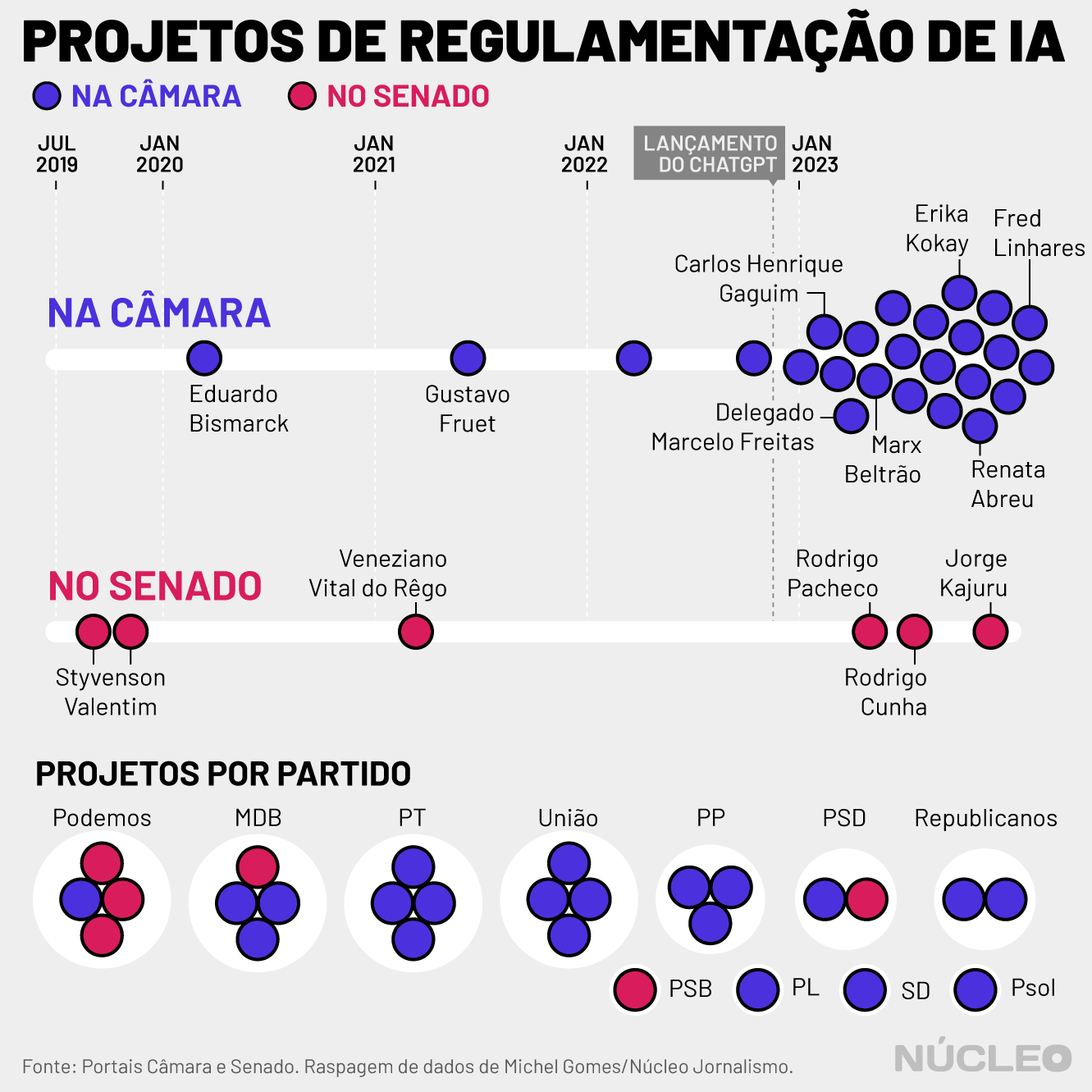

Assim como em diversos outros países, especialmente na Europa, o debate sobre regulação de inteligência artificial também tem avançado no Brasil, com o Senado liderando as discussões mais maduras até o momento.

Cinco projetos de lei estão sendo analisados por uma comissão de senadores que vai decidir qual deve ser a base legal de regras, princípios e limites para o uso e desenvolvimento da inteligência artificial no país.

Enquanto isso, na Câmara, pipocaram dezenas de PLs nos últimos meses, principalmente para punir abusos e disciplinar o uso, mas o debate de um marco legal ainda não avançou tanto por lá.

Criada em agosto de 2023, a Comissão Temporária Interna sobre Inteligência Artificial no Brasil (CTIA) já promoveu 10 audiências públicas para colher contribuições sobre o assunto, mas decidiu prorrogar os debates até maio de 2024 por causa de sua “complexidade”.

É ✷ IMPORTANTE ✷ PORQUE…

Uma comissão de juristas propôs uma regulação de IA baseada na mitigação de riscos que algoritmos podem causar a direitos fundamentais, o projeto considerado o mais avançado em discussão

Os setores privado e público, no entanto, vêem essa abordagem baseada em riscos como burocrática e prejudicial à inovação

Senadores da direita bolsonarista buscam desidratar as propostas que regulam IAs arriscadas

A intenção, nos próximos meses, é dar mais espaço à “perspectiva econômica” ao analisar o assunto, e não apenas à dimensão técnica, conforme justificativa do presidente da CTIA, o senador Carlos Viana (PODE-MG), para a prorrogação.

Atualmente, o setor privado está insatisfeito com uma abordagem de regulação de IA baseada na mitigação de riscos e na garantia de direitos, proposta por um grupo de juristas que discutiu a regulação do tema a pedido do próprio Senado ao longo de 2022.

QUAIS SÃO AS PROPOSTAS

Hoje, a CTIA discute os seguintes projetos de lei:

- O PL 5051/2019, proposto pelo senador Styvenson Valentim (PODE-RN);

- O PL 5691/2019, também proposto por Valentim;

- O PL 21/2020, proposto pelo deputado Eduardo Bismarck (PDT-CE), já aprovado pela Câmara Federal;

- O PL 872/2021, proposto pelo senador Veneziano Vital do Rêgo (MDB-PB);

- O PL 2338/2023, proposto pelo senador Rodrigo Pacheco (PSD-MG).

Entre os textos analisados pela CTIA, o PL 2338/23 “se apresenta como a proposta legislativa mais madura sobre o tema até o momento”, segundo o plano de trabalho da Comissão. A proposta de Pacheco se baseou no relatório produzido pela comissão de juristas que discutiu o assunto ao longo de 2022.

Por outro lado, as demais propostas estabelecem de forma genérica princípios e deveres para o uso de IA, sem necessariamente legislar sobre riscos ou a eventual responsabilização de agentes que causem impactos negativos com essas tecnologias ou as usem para violar direitos humanos.

O QUE DIZ O PL “MAIS MADURO”

O PL prevê que o desenvolvedor deve submeter seu sistema de IA a uma avaliação de impacto algorítmico antes de disponibilizá-lo. Essa análise irá identificar o grau de risco da aplicação à eventual violação de direitos, como os de proteção de dados ou a discriminação.

Se um sistema de IA for considerado de “alto risco”, ele deverá cumprir uma série de medidas de governança, que incluem a transparência na gestão e uso de dados, além da prevenção de vieses discriminatório no uso de IA. Se for de “risco excessivo”, sequer poderá ser usado.

“Quando olhamos a tendência global em termos de regulação de IA, no lugar de se criar regras universais para todos os agentes, você traz obrigações de acordo com o nível de risco do algoritmo”, diz a advogada Paula Guedes, pesquisadora do Data Privacy Brasil.

“Para você medir risco [de algoritmos de IA], precisa fazer uma avaliação. Quantas pessoas podem ser afetadas, se esse sistema lida com grupos vulneráveis, como idosos e crianças, ou cataloga filiação política e religião, e se usa dados pessoais ou informações humanas, por exemplo

– Paula Guedes, Data Privacy Brasil

São exemplos de algoritmos arriscados, segundo o PL 2338/2023:

Risco excessivo (proibidos):

— Os usados por governos para avaliar e classificar cidadãos com base em seu comportamento social ou personalidade e decidir sobre seu acesso a serviços e políticas públicas;

— Os que usem técnicas subliminares ou explorem vulnerabilidades humanas para induzir comportamentos prejudiciais à saúde, à segurança ou que afrontem a lei.

Alto risco (devem seguir regras de governança):

— Os usados para avaliar e monitorar estudantes, ou recrutar e classificar candidatos a emprego, e até mesmo gerir trabalhadores já contratados;

— Os aplicados na gestão e controle de fronteiras ou na segurança de infraestruturas críticas, como o abastecimento de água e eletricidade;

— Os sistemas usados pelo Poder Judiciário, inclusive para investigação e aplicação da lei, ou utilizados para fins de segurança pública ou em sistemas biométricos de identificação;

— Os usados para avaliação de capacidade de endividamento ou classificação de crédito, ou até mesmo para o acesso ou exclusão de serviços públicos e privados considerados essenciais;

— Os usados para estabelecer prioridades para serviços de resposta a emergências, como bombeiros ou na assistência médica;

— Os usados para auxiliar diagnósticos ou procedimentos médicos ou em saúde;

— Os usados em veículos autônomos, quando seu uso puder trazer riscos à integridade das pessoas;

No total, são 14 tipos de algoritmos considerados de “alto risco”;

Data Privacy Brasil + estudo sobre regulação de IA

Em 13 de dezembro, o Data Privacy lançou o estudo “Temas Centrais na Regulação de IA: o local, regional e o global na busca da interoperabilidade regulatória”, que foi uma das principais fontes usadas para a redação desta reportagem. Leia o estudo na íntegra aqui.

LOBBY CONTRÁRIO

De acordo com Guedes, há um “lobby grande” de setores privados, que preferem uma regulação mais baseada em “princípios” para o uso de IA e menos em obrigações que mitiguem riscos no uso dessas tecnologias.

Em meio às críticas de lobistas, em novembro, o relator da CTIA, Eduardo Gomes (PL-SE), disse à Agência Senado que iria buscar um “texto de convergência” para o marco legal e afirmou que “IA é o primeiro assunto que você conversa com o especialista hoje e dois meses depois ele sabe menos”.

“Eles querem uma regulação principiológica, ou não querem regulação no momento, para não ter que cumprir com várias obrigações”, explica Guedes.

A fala de Gomes ocorreu após uma audiência requerida pelo senador Marcos Pontes (PL-SP), na qual representantes de setores como os de indústria, agricultura e finanças pediram mais flexibilização e menos burocracia na regulamentação.

A principal queixa é que, nos termos do PL 2338/2023, muitos sistemas de IA já usados hoje seriam enquadrados como de “alto risco”, o que exigiria a adequação e reavaliação de diversas aplicações, medida considerada obstrutiva à inovação.

NO MUNDO DA LUA

Além do debate no Senado, no último dia 11.dez.2023, o Ministério da Ciência, Tecnologia e Inovação (MCTI) anunciou a revisão da Estratégia Brasileira de Inteligência Artificial (EBIA), lançada pela pasta em abril de 2021 pelo governo Bolsonaro.

Na época, o documento foi considerado atrasado e sem detalhamento.

“Foi bastante criticada porque, para ser uma estratégia, tinha que definir os atores responsáveis, direcionar as áreas mais adequadas para o Brasil crescer em IA enquanto protege direitos fundamentais, mas não previu nada de concreto”, avalia Guedes.

O ministro que lançou a EBIA à época foi o hoje senador Astronauta Marcos Pontes, vice-presidente da CTIA. Em meio aos debates, no fim de nov.2023, o astronauta propôs um substitutivo ao PL 2338/23. Na prática, o texto desidrata a abordagem baseada em riscos sugerida por especialistas.

A emenda de Pontes propõe que os sistemas de risco alto sejam definidos de acordo com “avaliações de probabilidade” de impacto, segundo a autonomia e o uso de dados pessoais de cada sistema. O modelo também descarta a proibição a IAs consideradas de risco excessivo proposta pelo projeto original.

Essa nova proposta do senador-astronauta “tem graves e irremediáveis problemas”, bagunça eventuais responsabilidades pelo uso de IA e carece de rigor técnico, segundo o advogado Filipe Medon, professor da FGV-RJ que participou da comissão de juristas que discutiu IA no Senado, em artigo publicado no Jota.

REPORTAGEM PEDRO NAKAMURA

DADOS MICHEL GOMES

ARTE E GRÁFICOS RODOLFO ALMEIDA

EDIÇÃO SÉRGIO SPAGNUOLO

Texto publicado originalmente no dia 27.12.2023 no site Núcleo.

DataPrivacyBr Research | Conteúdo sob licenciamento CC BY-SA 4.0